如果说今年的 AI 大爆发是过去几年的技术沉淀,终于从论文变成了封装好的工具,继而进入到了咱们的视野里。

那再往后看,短期内会是有试错能力的人或公司,开始把 AIGC 应用到自己的领域;长期看会是 AIGC 内容的大爆发。

前者,且看今年成都视听大会,国内一众互联网公司都在大谈特谈 AIGC,仿佛谁不拥抱 AI,谁就会落伍一样;

至于后者,那可就更好理解了,毕竟 AI 工具降低门槛是真的——

现在这个时间点看,有的 AI 能聊天,有的 AI 会作图,还有的 AI 可以作曲、做视频,先不说未来一定会出现的集大成工具,如果现在就把这些不同领域的 AI 聚到一起呢?

推特上的一位国外小哥@ Nick St. Pierre 就这么搞了,在我们还在惊呼,「卧槽 AI 还能这么搞」的时候,他利用多种 AI 工具,制作一条接近 30 秒的视频。

这样的「大作」是怎么实现的呢?且往下看。

AI 全制作

正常去拍摄一条视频应该怎么搞,最简单的,我们需要先撰写视频脚本,然后根据脚本去拍摄视频,最后加上后期特效,把音乐加进来。

国外这个小哥也是这么拆分任务的,不过其中编剧、导演、特效、配乐的活统统教给了 AI——

视频脚本的任务交给了 ChatGPT,让 ChatGPT 为一个主题是「一个男人坐在房间里」,风格为「科技感」的视频生成镜头。

光有视频脚本,没有画面感可不行,所以这个小哥根据脚本,用 Midjourney 生成了一张图片。

脚本有了,画面也有了,接下来就该开机实拍了,不过沙发好搞,图片里的发光球体要怎么准备呢?

反正后期都是交给 AI 生成,与其 DIY 个球,不如拿相似物品替代,瞅了一圈,小哥拿出了自己的卫生纸。

按例图简单找了角度,就在自己家里,用一部 iPhone 手机就拍出原始镜头。

有了原始镜头,就该搞后期特效了,毕竟你瞅上面这个视频片段,和例图里的科幻风可没半毛钱关系。

于是,小哥找来了 Runway 的 Gen-1 工具,拿例图给原始镜头迁移了风格:

等 3 个镜头全部制作完成,小哥用 Boomy 生成了一段符合心意的背景乐,近 30 秒的成片新鲜出炉。

这小小的短片,如果按传统的制作流程,3 天时间都算很高效的了,而小哥说在 AI 的帮助下,他只用了 3 个小时。。。

用 3 小时替代 3 天的工作量,说起来很容易,但小哥一定忽略了学习使用 ChatGPT、Midjourney、Runway Gen-1、Boomy 的过程。

虽然用过的小伙伴肯定知道,上述工具只要会用打字、会用翻译软件就能搞定,但用起来容易,用好难。

ChatGPT 大家已经不陌生了,下面就让我们拿迁移视频风格,AI 制作视频的 Runway Gen-1 举例。

Runway Gen-1

看了上周文章的小伙伴肯定知道,Runway 上周发布了自家最新的 Gen-2 模型,但发布归发布,一方面是炫肌肉,一方面就是纯纯画饼了。

何况在 Gen-2 发布的时候,Gen-1 还在内测,但没想到,随着 Gen-2 发布,Gen-1 上周直接开放使用了,而且给新注册的用户免费体验的额度。

地址:https://runwayml.com

我们只需要在官网主页右上角完成注册。

登录后会进入我们自己的工作台,新用户有 400 积分,右侧工具里就有「Video to Video」的选项。

点进去,是一个上传视频的界面。

是的,不像刚刚发布还没实装的 Gen-2,Gen-1 还不能够从 0 到 1 完整的创造视频,这也是为啥前面那位小哥还需要拿手机实拍的原因。

至于 400 积分,我们可以在右上角看到时间额度,每用 Gen-1 生成一段视频,会扣 14 积分,相当于你能用这 400 积分生成 28 段视频。

不过需要注意的是,每一段视频不能超过 5 秒,Gen-1 刚刚开放时还只是 3 秒,Runway 偷偷上调了额度。

至于需要我们提前准备的?也就一份原始视频了,这次我们是奔着体验来的,所以我从网上找了段小姐姐跳舞的视频。

在视频上传后,在视频预览的右侧,会有出现三种迁移风格的选项,分别是图片、预设风格、提示词:

提示词那个我试了试,完全没按我意思走,生成的更像是去年 AI 绘画那种不可名状的克苏鲁。。。

所以我这里重点展示一下图片,Runway 里提供了不少可供我们选择的 Demo,当然,像图片这种我们还能自己上传。

在风格选项下,是关于 AI 生成过程中的设置,基础其实就风格权重和种子两项。

、

但展开后,还有结构一致性、帧一致性、影响前景、背景的选项,具体的大家可以看看 Runway 给出的介绍。

地址:https://help.runwayml.com/hc/en-us/articles/15161225169171

选择好风格,设置好参数后,就可以点击生成了,等进度条读完,新风格的视频就做好了。

这是 Demo 里自带的赛博朋克风格图片转换后的视频:

这是 Demo 里岩浆图片转换的视频:

此外,我还拿 3D 转 2D 的工具生成了图片:

地址:https://huggingface.co/spaces/akhaliq/AnimeGANv2

这是转换后的新视频:

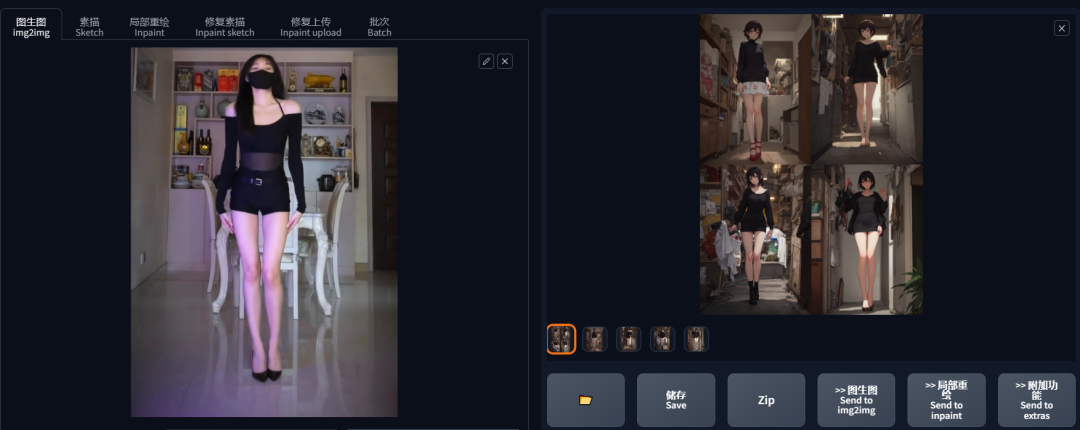

当然,我也用 Stable Diffusion 的图生图试了试。

效果如下:

能看出来 Gen-1 很努力的想把视频里的小姐姐转换成例图里的样子,但脸部效果确实一般,至少和小哥制作的视频是很有差距的。

问题出在了哪?以我拿两个号测试的结果而言——

1、原视频的镜头一定要稳,像小姐姐跳舞这种,动作细节一多,AI 处理效果就差。

2、原视频里有人物时,不要有口罩之类遮挡五官的地方,背景也最好干净一下,换句话说,不能给 Gen-1 太多自由发挥的空间。

3、例图的风格要明显,尤其是色彩、光线等等,这个需要我们在 AI 图生图时多下功夫了。

关于用 Gen-1 生成创意视频,大家可以看看 B 站这个搬自油管的教程,还有内测资格的 UP 主拿《中国奇谭》画风迁移狂飙的体验,相信你会有更好的理解。

教程:https://www.bilibili.com/video/BV1oY4y197vt

体验:https://www.bilibili.com/video/BV15P411o7oU

结语

我们今天只是初体验了下 Gen-1,而按发布时的说法,更给力的 Gen-2 会在这几周内实装,有机会肯定要体验一下。

至于你说 AI 有没有门槛?有的,至少如果我没有自己用过,总会不由自主的去误解当前 AI 的能力,觉得它无所不能或一无是处。

实话实说,单这个 Gen-1 在会用的人手中(比如国外的小哥)和不会用的人手中(比如现在的我)是不一样的。

不过可以肯定的是,AI 这玩意还远远没有达到上限,当未来的 AI 门槛更低,操作起来更傻瓜,AIGC 的大爆发是板上钉钉的。

而限制我们创作的,大概就是独属于人类的想象力了。

所以先用起来,先上手的就会有先发优势,新的产品发布,新的动态我每天都会在星球上不断更新,这个其实也是上周就发在星球上了,对 AI 感兴趣的小伙伴可以来咱们星球看看。

QQ 群:729224889 网站:wldxh.com